Vtuberの動きはどのように作られているのか、機材やソフトの違いで何が変わるのか気になる方向けにまとめます。2Dと3Dでの動かし方、顔や全身のトラッキング技術、配信時の処理までを順を追って解説します。機材選びや制作費の目安も触れるので、これから始める人や機能を理解したい人に役立つ内容です。

vtuberはどうやって動いてるのかが実例で分かる

Vtuberの動きは複数の技術と機材を組み合わせて作られます。顔の表情はフェイストラッキングで読み取り、全身の動きはモーションキャプチャやセンサーで再現します。2Dモデルではパーツごとの変形で表現し、3Dモデルではボーンやスキンで滑らかな動きを実現します。配信時にはリアルタイムにレンダリングし、映像合成やエフェクトを加えて視聴者に届けます。

実際の配信例を見ると、スマホやWebカメラで顔だけ追うライトな環境から、複数台カメラやフルボディのモーションキャプチャスーツを使う本格的な環境まで幅があります。目標や予算に応じて省略できる工程も多いので、まずは顔トラッキングから始めるケースが多いです。

扱うソフトやプラットフォームによって連携の仕方が変わるため、使うツールを事前に決めてセットアップを行うとスムーズです。次に、2Dと3Dでの違いや各技術の詳細を見ていきましょう。

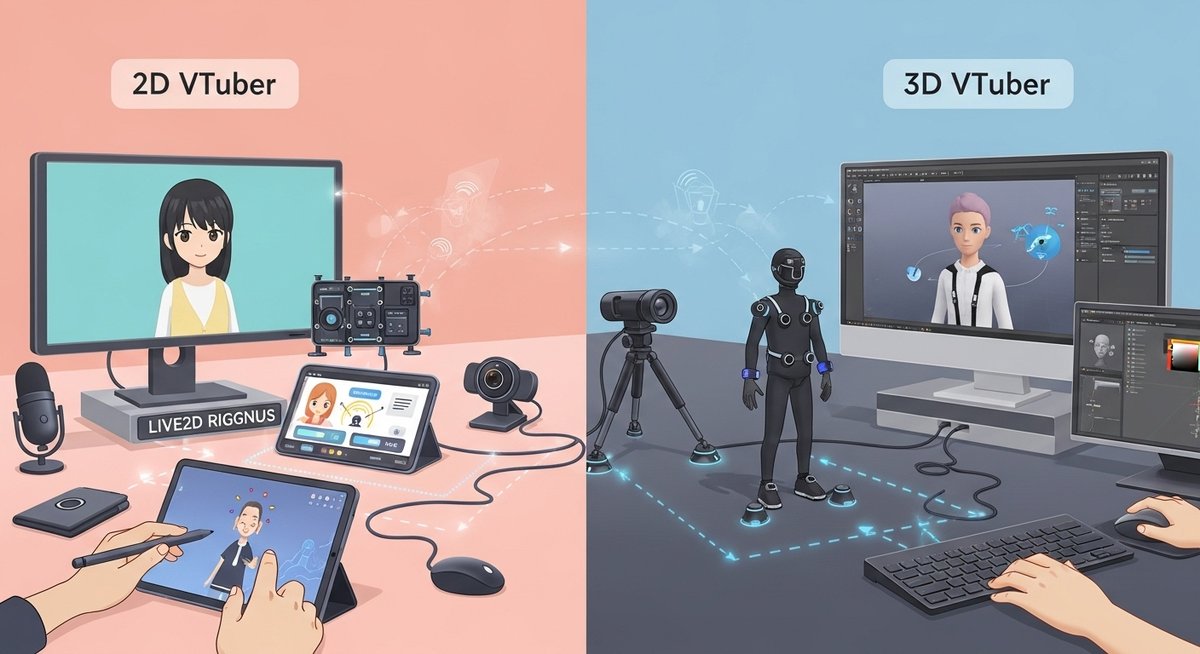

2Dと3Dで動かし方はどう違う

2Dモデルはパーツを分けてそれぞれを動かすことで表現します。パーツの回転やスケール、メッシュ変形を組み合わせてまばたきや口の動き、身体の傾きを表現します。Live2Dのようなソフトではパラメータを使って自然な動きを作り、軽い処理で動くため配信負荷が低めなのが特徴です。

一方3Dモデルはボーン(骨組み)とスキン(頂点の重み付け)で動きを付けます。ボーンを動かすとメッシュ全体が連動して動き、立体的で滑らかな動きになります。物理演算で髪や服の揺れを加えることもでき、表現の幅が広い反面、リアルタイムレンダリングの負荷や制作コストが高くなる傾向があります。

制作の流れも異なります。2Dはイラストをパーツ分けしてデフォーマーを設定、3Dはモデリング→リギング→スキニングと進みます。配信時の扱いやすさ、表現したい見た目で選ぶと良いでしょう。

顔の動きはフェイストラッキングで反映される

フェイストラッキングはカメラで顔の特徴点や表情の変化を検出して、その動きをアバターの表情に反映する技術です。目の開閉や口の開き、眉の動きといった要素が中心で、スマホやWebカメラでもある程度の精度で取得できます。専用ソフトは検出結果をパラメータ化してアバターに送ります。

検出精度はカメラの画質や照明、角度で変わります。明るい場所で正面を向くと安定しますが、横向きや暗所では認識が不安定になりやすいです。高精度を求める場合は専用ハードや赤外線カメラを使うと改善します。

一部のソフトは表情補正やフィルタを備え、ノイズを抑えたり誇張表現を加えたりできます。配信中に表情が自然に伝わると視聴者の反応も良くなりやすいので、顔検出の基本設定と照明環境の整備は重要です。

全身の動きはモーションキャプチャで再現される

全身モーションキャプチャは、身体の関節や姿勢をリアルタイムで取得してアバターに反映します。光学式や慣性式、カメラベースの手法があり、用途や予算に応じて選ぶことが多いです。立ち位置や床反射に影響される光学式は高精度ですが設備が必要で、慣性式は屋外でも扱いやすいのが特徴です。

フルボディが不要な場合は上半身だけをトラッキングする方法もあります。ハンドトラッキングやコントローラーを併用すると手の細かな動きも表現できます。モーションデータは補間や補正を施して滑らかな動きに整えます。

配信時にはモーションラグやノイズ対策が重要です。ソフト側で簡易フィルターをかけたり、遅延を許容する設定にすることで安定した配信が可能になります。視聴者参加型の動きや複雑なアクションを行う場合は、事前にリハーサルを行うと安心です。

配信ではリアルタイムレンダリングと映像合成で送られる

配信ではアバターのレンダリングをリアルタイムで行い、映像合成ツールで画面レイアウトやエフェクトを加えます。OBSのような配信ソフトが中心となり、アバター映像、ゲーム画面、チャット表示などを重ねて配信ストリームとして出力します。リアルタイムレンダリングはGPU性能に依存するため、PCスペックの確認が必要です。

エフェクトやライティングを加えると見栄えは良くなりますが、その分負荷が上がります。軽い演出で滑らかさを優先するか、重い演出で見た目を追求するかは優先度に応じて調整します。音声と映像の同期も重要で、リップシンクや音声遅延の補正を行うことで違和感の少ない配信ができます。

また、ビットレートや配信プラットフォームの制限も考慮しましょう。視聴者の回線状況に合わせた画質設定や、配信中のトラブル対策として録画を同時に行うと安心です。

アバターの種類で動かし方が変わる

アバターの形式によって必要な工程や機材が変わります。2D、2.5D、3Dなど表現の違いでソフトや処理負荷が異なるため、目的に応じた選択が大切です。顔だけ動かす簡易的な方法から、全身を再現する本格的な方法まで幅があります。次に各タイプごとの特徴を説明します。

2Dアバターの基本的な動かし方

2Dアバターはイラストをパーツ分けして、それぞれを動かす仕組みです。目や口、髪、服などをレイヤーで分け、パラメータやデフォーマーで変形させて動きを作ります。パーツ同士の重なりや動きのつながりを調整することで立体感を出します。

パフォーマンス面では軽く、低スペックのPCやスマホでも扱いやすい点が魅力です。表情や首の傾き、簡単な手振り程度なら十分に表現できます。制作はイラスト制作→パーツ分割→ソフトでモデル化という流れが一般的で、制作時間や費用は3Dより抑えられる場合が多いです。

配信ではフェイストラッキングやキーボードでのモーション切り替えを併用して動かします。視聴者とのやり取り重視なら、手軽さを優先した2Dアバターが選ばれることが多いです。

Live2Dで表情と動きを作る流れ

Live2Dは2Dイラストを立体的に動かすための代表的なツールです。まず完成したイラストをパーツごとに分割し、パラメータを割り当てて動きを設定します。デフォーマーやメッシュ変形を使って自然な曲線や回転を表現します。

次にパラメータ間の連携を設定し、まばたきや口の開閉、首の傾きなどを組み合わせて自然なアニメーションを作ります。追加で物理演算を使えば髪や服の揺れもリアルに表現できます。

完成したモデルはライブ配信ソフトと連携してリアルタイムで動かせます。フェイストラッキングやモーションキーで表情を制御しやすく、手軽に導入できる点が魅力です。制作にはイラストの分割やパラメータ調整の作業が必要ですが、学習コストは3Dより低めです。

3Dアバターのリギングとスキニングの役割

3Dアバター制作ではリギングとスキニングが重要な工程です。リギングはモデルにボーン(骨組み)を入れて関節や動きの軸を設定する作業で、どの部分がどのように回転するかを定義します。正確なリギングがあると自然な動きがしやすくなります。

スキニングはメッシュ(頂点)に対してボーンの影響度を割り当てる作業です。これによりボーンを動かしたときにメッシュがどのように変形するかが決まります。適切なウェイト付けを行うことで、関節付近の不自然な引きつりを防げます。

リギングとスキニングは経験がものをいう部分で、品質によって動きの滑らかさが大きく変わります。外注する場合はこれらの工程の詳細を確認すると後の調整が楽になります。

モデル制作の費用と作成の目安

モデル制作費は2Dと3Dで大きく異なります。2Dモデルはイラスト制作とパーツ分割、Live2D化を含めて比較的抑えられることが多く、予算に応じて幅があります。簡易なモデルなら比較的安く済ませられます。

3Dモデルはモデリング、リギング、スキニング、テクスチャ、物理設定など工程が多く、費用は高めになります。求める品質や表現の細かさ、アニメーションの数で価格が上下します。手足りない部分は外注で補うことも可能ですが、依頼内容を明確にした見積もりを取ることが重要です。

予算に応じて段階的に導入する方法もあります。まずは2Dでスタートし、後に3Dへ移行するケースや、部分的に3Dを取り入れるハイブリッドな方法も有効です。

動きを読み取る主な技術と機材

動きを取得する技術には複数の方式があり、それぞれ利点と制約があります。用途や予算、求める精度で最適な方式を選ぶことが重要です。ここでは代表的な技術ごとの特徴と利用シーンを紹介します。

フェイストラッキングの仕組みと精度差

フェイストラッキングはカメラ映像から顔の特徴点を解析し、表情や頭部の向きを検出します。アルゴリズムは顔のランドマーク検出や深層学習を使うことが多く、ソフトごとに検出の精度やパラメータ化の方式が異なります。

高性能なモデルは細かな表情変化まで拾えますが、計算負荷が上がります。逆に軽量モデルは粗めの動作しか捉えられませんが、低スペック環境でも安定します。照明や顔の角度、表情の強さも精度に影響しますので、環境を整えて使うことが大切です。

ソフトによっては学習済みモデルの更新やカスタムキャリブレーションが可能で、個人差のある顔の形にも対応しやすくなります。

Webカメラやスマホでのトラッキング方法

Webカメラやスマホは手軽に始められるトラッキング機器です。多くのフェイストラッキングソフトは標準カメラを利用したトラッキングに対応しており、初期投資を抑えたい場合に最適です。スマホの高性能カメラは解像度やフレームレートが高く、安定した検出が期待できます。

注意点としては、照明とカメラの角度の調整が重要になることです。正面を向き、顔が明るく映るようにすれば検出精度が上がります。動きが激しいと追従が追いつかない場合があるため、極端なポーズや高速の首振りには向きません。

手軽さとコストの低さから、多くの入門者はまずWebカメラやスマホで始めます。

光学式トラッキングの特徴と利点

光学式トラッキングは複数のカメラで反射マーカーや専用マーカーを追跡する方式です。高精度かつ低遅延で動きを取得できるため、プロの制作現場で使われることが多いです。細かな指の動きや複雑な全身アクションも高精度に再現できます。

ただし、専用のカメラやマーカー環境、キャリブレーションが必要で導入コストと準備工数がかかります。セッティングスペースや照明条件にも敏感なので、専用のスタジオ環境があると効果を発揮します。

高品質な収録や配信を目指す場合は光学式が有力な選択肢となります。

慣性式センサーの特徴

慣性式センサーはIMU(加速度・角速度センサー)を用いて動きを計測する方式です。モーションキャプチャスーツや小型のセンサーユニットで利用され、屋内外問わず使いやすい点がメリットです。配線が少なく、比較的取り扱いが簡単でコストも光学式より抑えられます。

短所としては、ジオメトリのドリフトや長時間使用での誤差蓄積が発生しやすい点があります。これを補正するためにソフト側でフィルタ処理や外部の位置検出と組み合わせる場合があります。動きの自由度が高い用途や移動が多い配信では有用です。

配信環境と配信の進め方

配信環境は使用するアバターや演出内容で求められるスペックが変わります。安定した配信にはPC性能、周辺機器、ソフトの設定、そしてネット回線が重要です。ここでは基本的な構成と進め方、演出で使える技術を紹介します。

必要なPCスペックと周辺機器の目安

配信をスムーズに行うにはCPU、GPU、メモリのバランスが重要です。2Dアバター中心なら中~上位のCPUと内蔵GPUでも問題ない場合がありますが、3Dリアルタイムレンダリングや複数のエフェクトを使う場合は dedicated GPU(例:RTXシリーズ相当)を推奨します。メモリは16GB以上あると安心です。

周辺機器としては高品質なマイク、Webカメラやキャプチャーボード、照明機材があると視聴体験が向上します。モーションキャプチャ機器を使う場合はそれに応じた受信機やハブも必要です。安定した有線LAN接続も重要で、配信中の遅延や切断を防ぎます。

機材選定は配信の目標と予算に合わせて段階的に整えていくと負担が少なくなります。

OBSや外部ツールとの連携方法

OBSは複数の映像ソースを合成して配信する中心的なツールです。アバターのレンダラーやトラッキングソフトと仮想カメラやウィンドウキャプチャで接続し、シーンやソースを切り替えながら配信できます。音声はルーティングソフトで仮想入力にまとめると管理が楽になります。

外部ツールと連携する際は、遅延やフレームレートの差を調整して同期を取ることが大切です。配信用のシーンを事前に作成し、テスト配信で動作確認をする習慣を付けると安心です。

キー操作やホットキーを登録しておくと、配信中の画面切替や効果発動がスムーズに行えます。

ライブ演出で使われるARやホログラムの概略

ARやホログラム演出は視聴者の目を引く手段として使われます。ARはカメラ映像とCGをリアルタイムで合成し、Vtuberの周りにエフェクトや情報を表示することができます。ホログラム風の演出は透過や層構造の合成で立体感を出します。

これらを使うと配信の見栄えが上がりますが、演出の重さや複雑さが増すためPCやソフトの負荷も上がります。演出は多用せず、場面ごとに切り替えられるように整理すると運用が楽になります。

音声処理とリップシンクの作り方

音声はマイク入力のノイズ除去、イコライジング、コンプレッサー処理で聞きやすく整えます。OBSや専用ソフトでこれらを処理しつつ、配信プラットフォームに適した音量で送ることが重要です。音声遅延があるとリップシンクにズレが生じるため、映像と音声の同期を確認してください。

リップシンクは音声入力の音量や周波数解析を基に口の開閉を制御する方式が一般的です。フェイストラッキングと組み合わせると自然な口の動きを作れます。テスト配信で実際の会話や歌で確認し、パラメータを細かく調整しましょう。

これだけでわかるvtuberの動かし方

ここまでの内容を踏まえると、Vtuberの動きは「入力(カメラ・センサー)」→「トラッキング処理」→「アバターへ反映」→「配信合成」の流れで作られていることがわかります。始める際は目的と予算を決め、まずは顔トラッキングから試すのがおすすめです。

不足を感じたらモーションキャプチャや外部演出を段階的に導入すると負担が少なくなります。機材やソフトの選択次第で表現の幅は大きく広がるため、自分の配信スタイルに合った構成を見つけていきましょう。